Uma equipa de investigadores de Hong Kong e do Japão desenvolveu uma nova abordagem para integrar informações visuais e tácteis, permitindo que mãos e braços robóticos manipulem objectos enquanto respondem de forma adaptativa ao ambiente.

Em comparação com os métodos convencionais, normalmente baseados em visão computacional, a nova abordagem, que os investigadores chamam de física multimodal, alcançou taxas de sucesso mais elevadas, um avanço significativo no campo da IA incorporada.

O método aprimorado de IA física foi capaz de manipular objectos com precisão, combinando múltiplas entradas sensoriais para gerar movimentos adaptativos e responsivos. A equipa afirmou que há “possibilidades quase infinitas para aplicações práticas deste tipo de robôs de assistência.”

De acordo com o site Inovação Tecnológica, a machine learning tem sido utilizada para apoiar a Inteligência Artificial na aprendizagem de padrões de movimento humanos, permitindo que os robôs realizem tarefas comuns de forma autónoma. Estes sistemas dependem principalmente de informações visuais e carecem dos julgamentos tácteis que os seres humanos fazem sem pensar, como distinguir a textura dos materiais, a frente e o verso dos objectos ou se estão a segurar a parte quente de uma chávena de café.

“Para superar essas limitações, desenvolvemos um sistema que também permite decisões operacionais com base na textura dos objectos-alvo, que são difíceis de avaliar apenas com base em informações visuais”, explicou o professor Mitsuhiro Hayashibe, da Universidade de Tohoku. “Esta conquista representa um passo importante para a realização de uma IA física multimodal que integra e processa vários sentidos, como visão, audição e tacto, assim como nós fazemos.”

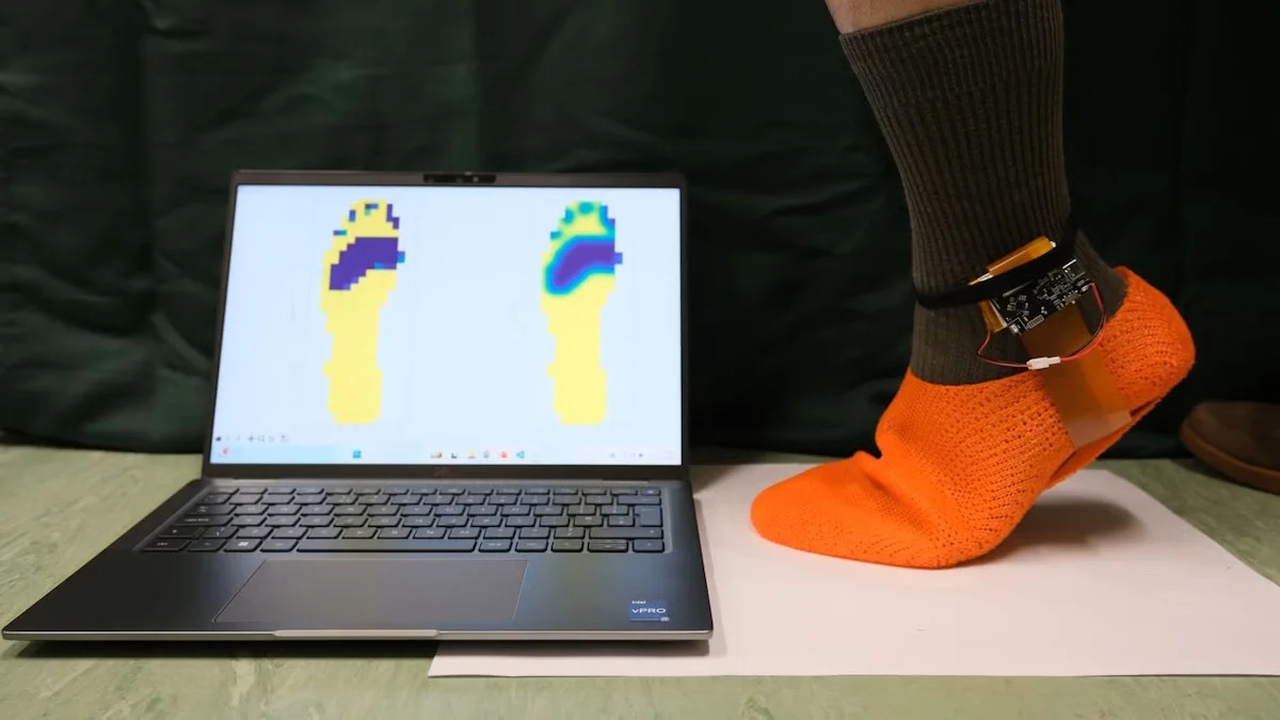

Em vez de chávenas de café, a equipa utilizou como ambiente de teste o facto de ser muito mais fácil identificar a parte da frente e de trás do velcro ao tocá-lo do que ao discernir a sua aparência, como os sistemas de visão artificial tentam fazer. O sistema robótico de visão e toque integra um sensor táctil para capturar informações de textura detalhadas, que são então utilizadas para apoiar a visualização em tempo real por câmaras. Isto permite-lhe lidar com tarefas relacionadas com textura que os métodos baseados em câmaras não conseguem realizar.

Usando o novo sistema, o robô de teste foi capaz de realizar operações bimanuais mesmo em tarefas em que as diferenças entre a frente e o verso e a aderência dos objectos manuseados são cruciais, como no caso do velcro e do fecho e abertura de zíperes.

Painel

Painel  Cores

Cores